本文转自微信公众号王知鱼

固态硬盘(SSD)作为高性能存储的主流选择,其容量也在不断突破极限。为了满足这一需求,存储行业正积极推动更高密度 NAND 闪存技术的应用,其中四层单元(QLC)技术因其更高的存储密度而备受关注。然而,QLC 技术在带来容量飞跃的同时,也带来了性能、耐用性和服务级别协议(SLA)等方面的挑战。理解这些挑战并探索相应的解决方案,对于充分发挥高容量 SSD 的潜力至关重要。本文将深入探讨高容量 QLC SSD 的技术特性、面临的挑战,以及行业为应对这些挑战所做的努力,特别是大块大小(LBS)等创新技术如何影响未来的存储格局。

-

了解高容量 SSD 发展背后的技术驱动力及面临的固有挑战。 -

认识到 QLC SSD 在性能和可靠性方面与 TLC SSD 的差异,以及这些差异在不同工作负载下的具体表现。 -

理解存储系统性能是一个端到端的概念,网络、缓存、软件等因素与 SSD 本身同样重要。 -

获悉大块大小(LBS)等前沿技术如何被视为解决未来高密度 SSD 可用性挑战的关键

图片展示了固态硬盘(SSD)容量的发展趋势。

图表通过一条上升的曲线和不同容量点的标注(从 32GB 到 256TB),清晰地表明 SSD 的容量一直在显著增长,并且这种增长趋势预计将持续下去。不同的容量点展示了不同形态的 SSD 产品,反映了技术的演进。

支撑SSD容量增长的技术

-

增加L2P表位数:通过增加逻辑到物理(L2P)表中每个条目的位数,可以直接扩大SSD支持的最大容量。例如,从32位增加到34位可以将容量上限提升到64TB 。 -

子驱动器技术:将SSD的存储空间划分为多个较小的逻辑单元(子驱动器),每个子驱动器拥有自己的L2P映射表,从而实现更精细的磨损均衡和管理 。 -

增大IU页大小:增加间接单元(IU)的大小,例如从4KiB增加到8KiB,可以减少L2P表所需的DRAM容量,但可能会引入读-修改-写(RMW)操作,影响小I/O请求的性能 。

SSD容量增长面临的问题

-

DRAM成本和性能:增加L2P表位数和IU大小会消耗更多的DRAM资源,并可能引入额外的复杂性和延迟 。 -

磨损均衡挑战:子驱动器技术虽然有助于局部磨损均衡,但子驱动器之间的全局磨损均衡仍然是一个挑战 。 -

兼容性和复杂性:增加IU大小可能影响旧有系统的兼容性,并增加固件和硬件设计的复杂性 。

图片列出了影响存储系统整体性能的几个关键因素。

这些因素包括主机(服务器)的处理能力、系统使用的缓存或缓冲内存、网络连接的带宽、软件本身的开销和潜在限制、存储控制器或系统的处理能力,以及最终的存储设备(如 SSD)自身的性能。图中的系统架构示意图也形象地展示了这些不同组件如何相互关联,共同决定了存储系统的表现。

强调了网络带宽是影响存储系统性能的关键因素之一,并指出它可能是系统的瓶颈。

明确提出 25 Gbps 和 100 Gbps 的网络速度正在成为,并且预计在不久的将来会占据主导地位。

图中的柱状图(服务器端口速度演进)显示了从 2020 年到 2025 年不同网络速度的市场份额变化趋势,印证了 25 Gbps 和 100 Gbps 的增长和主导地位。

列出了五个关于 QLC(四层单元)SSD 性能的可能误解或讨论点。

-

随着技术发展,QLC 的核心速度是否能赶上 TLC(三层单元); -

更快的接口(如 PCIe Gen5/Gen6)是否能提升 QLC 性能; -

NAND 接口技术的进步(如 Toggle 5.0, SCA)对 QLC 的影响; -

强大的主控芯片和高端 DRAM 是否能改善 QLC 性能; -

以及 SSD 性能是否会随着容量增加而提升。

图片通过图示解释了不同类型 NAND 闪存(SLC, MLC, TLC, QLC)的电压分布特性。

图表显示,随着每个单元存储的比特数增加(从 SLC 的 1 比特到 QLC 的 4 比特),所需的电压电平数量呈指数级增长(从 2 个到 16 个)。这意味着相邻电压电平之间的“距离”或电压差显著减小,并且每个状态的电压分布曲线变得更窄。图片中的文字特别强调了 QLC 的电压分布更窄,且相邻电平距离更短,这暗示了读写数据的复杂性增加,以及相对于低比特/单元技术而言,可能在噪声容忍度和耐用性方面面临更大的挑战。

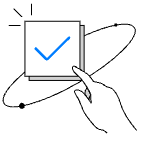

图片解释了 QLC SSD 需要更长编程(写入)时间的原因。

图片指出,由于需要复杂的写入算法来精确设置每个单元中的多个电压电平,QLC 设备的编程时间会更长。作为示例,图片展示了增量步进脉冲编程(ISPP)技术。图示说明了 ISPP 的工作原理:通过施加一系列逐渐增加的电压脉冲,并在循环之间进行验证,来逐步精确地调整单元的阈值电压。"ISPP 的效果" 图表直观地展示了这一过程如何使得电压分布曲线变得更尖锐、更分明,这对于可靠地区分 QLC 中的 16 个电压电平至关重要。这种复杂的编程过程直接导致了 QLC 相对于每单元存储比特数较少的技术而言,写入时间更长。

图片对比了影响高容量 QLC SSD 和 TLC SSD 性能的关键因素。

图片强调,对于高容量 QLC SSD 而言,并行通道数(# of ways)以及 NAND 闪存的 AC 参数(如读取时间 tR 和编程时间 tPROG)是决定性能的主要因素。

表格细分了不同操作(顺序读写、随机读写)下的性能影响因素:对于顺序读取,两者都受限于主机接口带宽;而对于随机读取,QLC 主要受并行通道数和读取时间 tR 影响,TLC 受 tDMA 影响。对于顺序和随机写入,两者都受并行通道数和编程时间 tPROG 影响,TLC 还列出了 tDMA。这表明,优化并行通道数以及 NAND 内部的读写时序参数对于提升高容量 QLC SSD 的性能至关重要,特别是在随机操作和写入方面。

QLC vs. TLC 性能差异对比

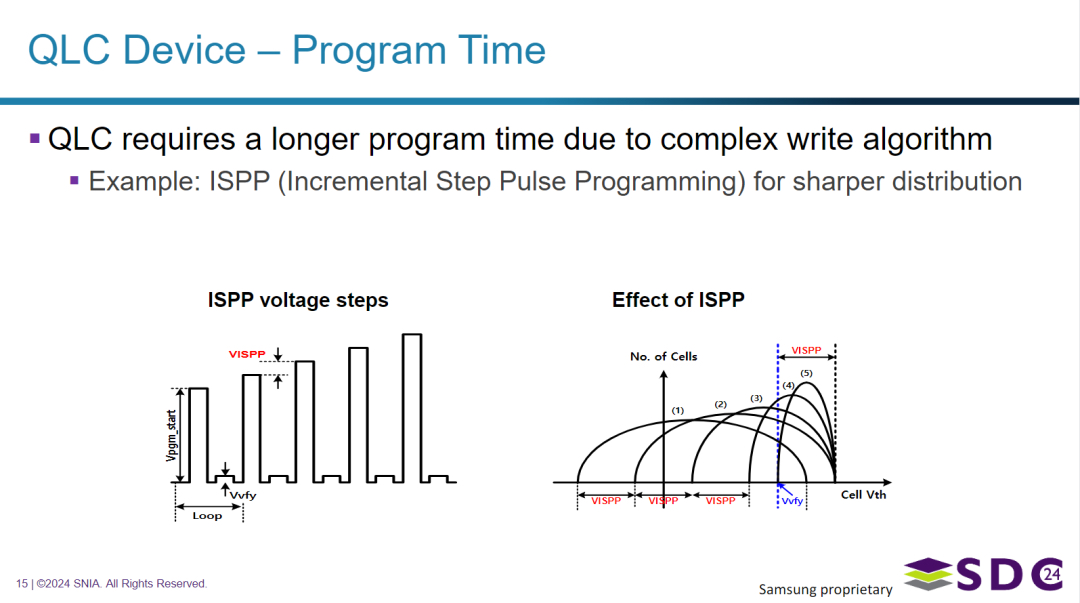

图片对比了市售的 16TB TLC SSD(使用 PCIe Gen5 NVMe 接口)和 16TB QLC SSD(使用 PCIe Gen3 NVMe 接口)的存储性能。

表格列出了顺序读写和随机读写的性能指标。数据显示,尽管容量相同,但 TLC SSD 在所有测试指标上均显著优于 QLC SSD,特别是在顺序写入、随机读取 IOPS 和随机写入速度方面差距巨大。这反映了 TLC 和 QLC NAND 闪存固有的性能差异,同时也受到接口代际(PCIe Gen5 vs Gen3)的影响,尤其是在顺序读写方面。

| 操作类型 | 16TB TLC SSD PCIe Gen5 NVMe | 16TB QLC SSD PCIe Gen3 NVMe |

|---|---|---|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

图片展示了一个大规模并行处理(MPP)数据库环境(具体为 Greenplum DB)的存储性能用例分析。

它比较了使用 SATA SSD、TLC SSD (PCIe Gen5 NVMe) 和 QLC SSD (PCIe Gen3 NVMe) 的三种配置。分析表明,该工作负载主要以随机读取为主(占总 I/O 的 61%)。一个关键发现是,虽然从 TLC 配置切换到 QLC 配置时观察到 30% 的性能下降(尽管两者的容量密度和每节点配置相似),但 QLC 配置的性能比典型的配备 SATA SSD 的设备高出 29%。这表明,对于这种以随机读取为主的特定数据库工作负载,QLC SSD 相对于传统的 SATA SSD 提供了显著的性能提升,即使其性能未能达到高端 TLC PCIe Gen5 SSD 的水平。图中的柱状图直观地支持了这些性能对比,并展示了在不同工作负载类型下的表现。表格则详细列出了各种配置的系统规格。

从右二柱状图来看,查询场景QLC性能较SATA接口还是要高上不少。

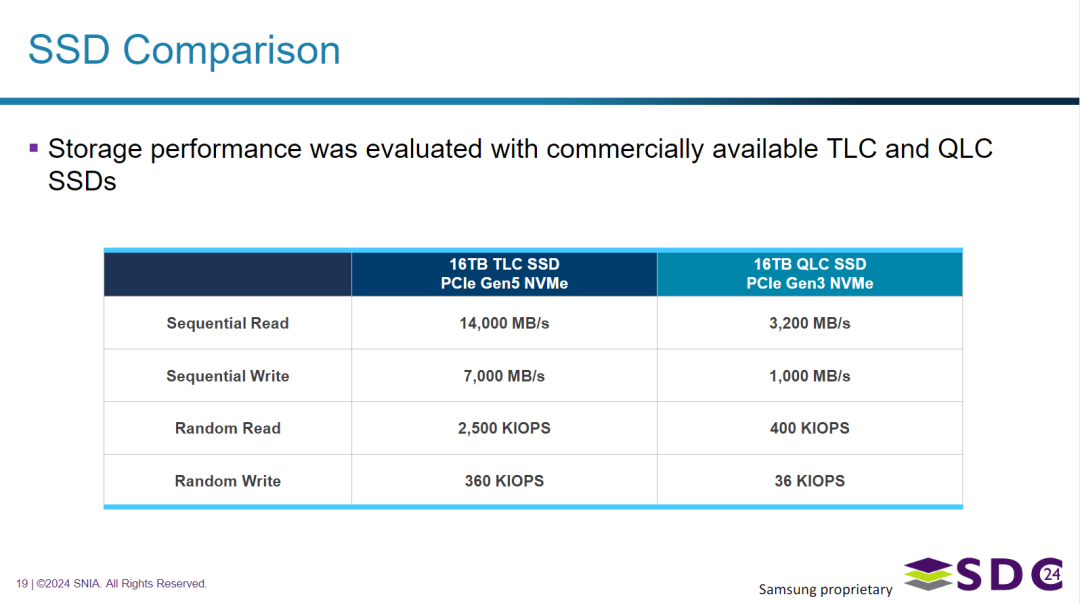

图片展示使用 NVMe-oF 技术的块存储。

图表描绘了一个分布式存储架构,其中虚拟机通过网络使用 NVMe-oF TCP 访问存储。图片中的关键点指出,在缓存命中率较高的工作负载中,QLC SSD 性能带来的影响较小。这一点通过三个柱状图得到支持,这些图表比较了 TLC 和 QLC 在不同数据库基准测试(YCSB 在 MongoDB 上、Sysbench 在 MySQL 上、PGbench 在 PostgreSQL 上)中的性能。在这些严重依赖缓存的工作负载中,TLC 和 QLC SSD 之间的性能差异相对较小(MongoDB 为 -13%,MySQL 和 PostgreSQL 仅为 -2%),这表明当数据经常从缓存而非直接从 SSD 提供时,底层 NAND 技术(QLC 与 TLC)固有的性能差异变得不那么显著。

图片讨论了 QLC SSD 存储对可用性服务级别协议 (SLA) 的影响,特别是数据重构时间(例如在 RAID 配置中)。

图表比较了不同容量下 HDD、TLC SSD 和 QLC SSD 的理论重构时间。图示表明,虽然 HDD 的重构时间随容量显著增加且最慢,QLC SSD 的重构时间远低于 HDD,但会随容量略有增加,这与 TLC SSD 基本保持不变的情况不同。图片中的文字确认了 QLC 重构时间随容量增加而增加,但也指出更高性能的 QLC SSD 可以改善 SLA。图表直观地支持了 QLC 重构时间虽然高于 TLC,但显著优于 HDD,并且存在改进潜力(通过箭头指示)的观点。

尽管 QLC 的特性(如较慢的写入/重构)给可用性 SLA 带来挑战,但 QLC 技术的进步可以帮助缓解这些问题。

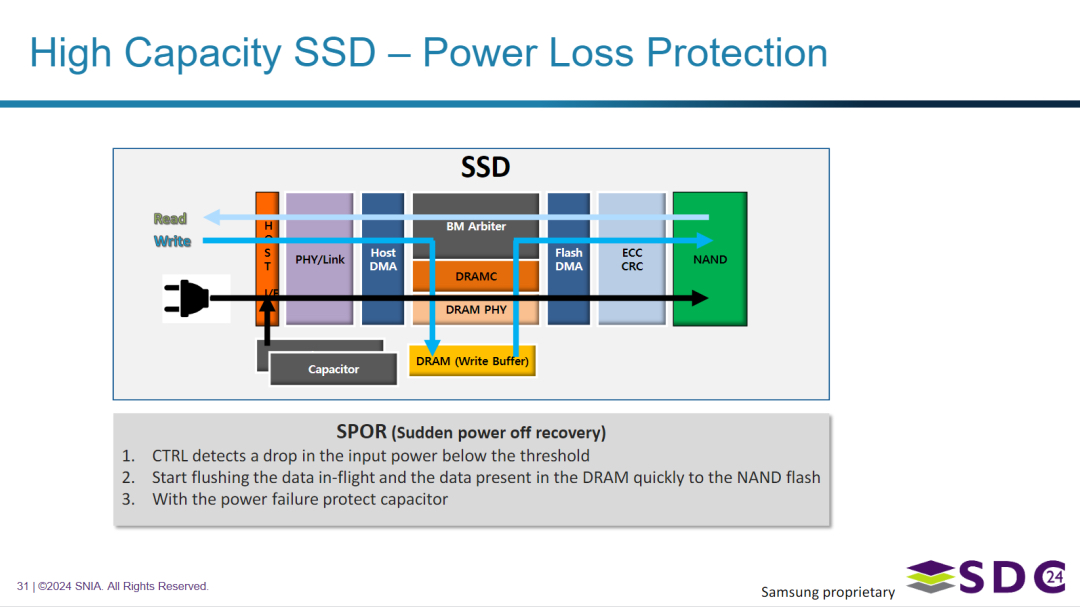

图片解释了高容量 SSD 中的掉电保护机制,特别是突发掉电恢复 (SPOR)。

图表展示了参与掉电保护的内部组件,包括掉电保护电容器。SPOR 的步骤被描述为:首先,控制器检测到输入电源降至预设阈值以下;其次,它利用掉电保护电容器储存的能量,快速将正在传输的数据(“in-flight”)以及存储在 DRAM 写入缓存中的数据写入 NAND 闪存。这一步骤对于在意外断电时保证数据完整性和防止数据损坏至关重要。

图示结构对于理解SSD的数据读取与写入过程也有不少帮助。

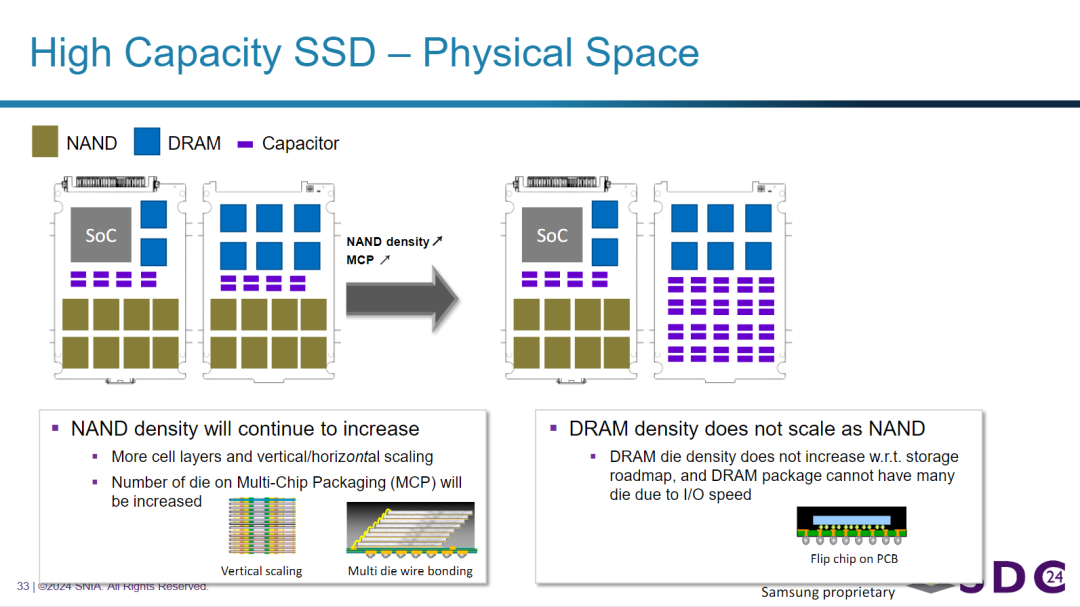

讨论了高容量 SSD 中 NAND 闪存和 DRAM 在物理空间和密度扩展方面的差异。

图示说明,NAND 密度通过增加单元层数(垂直扩展)和在多芯片封装 (MCP) 中集成更多芯片等方式持续显著增加。显示了在相同的物理空间内,通过更密集的堆叠可以实现更高的 NAND 容量。与此形成对比的是,图片强调 DRAM 的密度扩展速度不如 NAND,这主要是由于 I/O 速度的限制以及在封装中堆叠大量 DRAM 芯片的困难。

这解释了为什么随着 NAND 技术进步使 SSD 容量大幅增长,DRAM 的相对用量可能不会按比例增加,从而可能影响那些高度依赖 DRAM 缓存的性能特性。图示直观地展示了在高密度 SSD 中 NAND 相对于 DRAM 的比例增加。

理解这一趋势的关键在于“掉电保护”(Power Loss Protection / SPOR)机制。

- 掉电保护的需求:

高容量 SSD,尤其是那些具有 DRAM 缓存的,在正常工作时会将部分待写入的数据或映射表存储在高速的 DRAM 中。如果突然断电,这些位于 DRAM 中的数据将会丢失,导致数据损坏或不一致。掉电保护功能(SPOR)就是在检测到外部电源中断时,利用电容器储存的电能,为 SSD 控制器提供短暂的工作时间,以便将 DRAM 中的关键数据快速写入到安全的 NAND 闪存中。 - 容量增加意味着需要保护的数据可能更多:

随着 SSD 容量的增加(通过更高密度的 NAND 实现),其内部 DRAM 缓存的大小通常也会随之增加,或者在写入操作中需要处理的数据量更大。 - 更大的电能储备:

为了在掉电时能够有足够的时间和能量将这些可能更多的数据从 DRAM 成功写入到数量更多、密度更高的 NAND 芯片中,就需要更多的电能储备。 - 电容器的作用:

电容器是提供这种短暂电能储备的关键组件。增加电容器的数量或总容量,可以提供更长的掉电保持时间和更大的放电能量,从而确保在断电过程中有足够的能力完成数据闪存操作。

因此,右侧图中 Capacitor 数量的显著增加,直接反映了高容量 SSD 在掉电保护方面需要更大的电能支持,以应对更高容量和更复杂写入流程带来的数据保护需求。这是确保 SSD 在突发断电情况下数据不丢失或损坏的关键设计考虑。

图片提出将大块大小(LBS)作为解决高密度 QLC SSD 的服务级别协议(SLA)挑战的一种方案,旨在提升顺序写入和随机读取性能。

图示表明,利用高密度 NAND 和可能更大的块大小(LBS)可以在 SSD 内部重新分配空间,特别提到为更多的电容器分配空间(这与之前讨论的掉电保护相关)。图下方的文字强调,尽管 NAND 制造商正在开发高密度 NAND,但要有效实施 LBS,需要存储生态系统中的各个环节(包括 SSD、存储软件、操作系统、平台和虚拟机监控程序等)进行行业层面的协作,以建立一个完整的 LBS 生态系统。这表明,要发挥高密度 QLC 的优势(可能通过 LBS),不仅仅是 SSD 硬件问题,还需要更广泛的行业支持来推广新的块大小标准或方法。

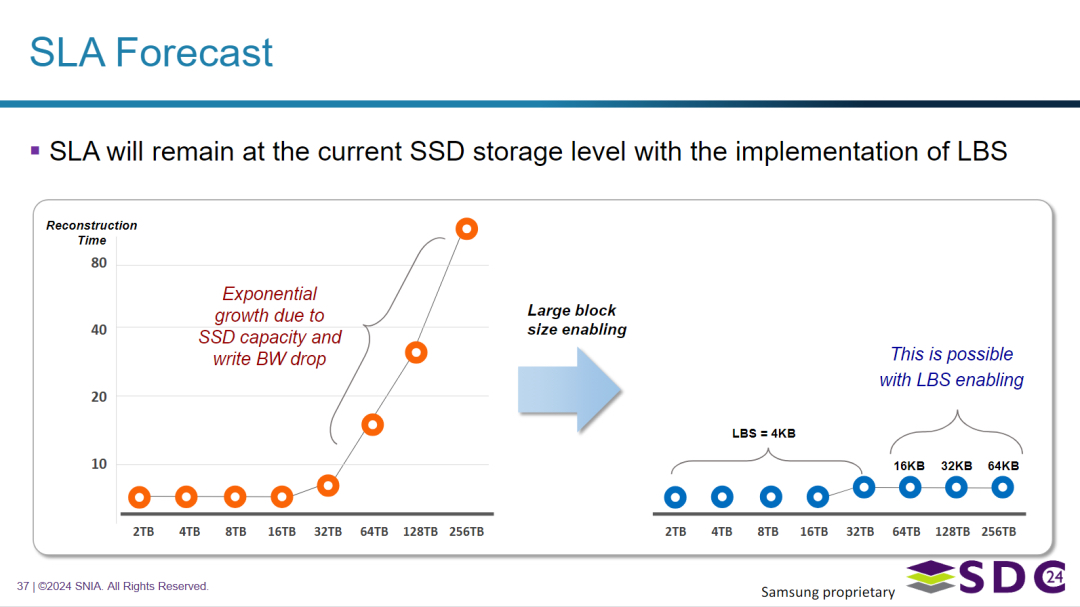

图片对服务级别协议(SLA)进行了预测,特别关注大块大小(LBS)对重构时间(对可用性至关重要)的影响。

图表显示了一个预期的挑战:如果不采用 LBS,随着 SSD 容量的增加,重构时间预计将呈指数级增长,这可能是由于高密度 NAND 的特性以及规模化后有效写入带宽可能下降所致。然而,图片预测,通过实施和启用 LBS,重构时间可以在容量增加的同时保持在一个较低的水平,有效地将 SSD 存储的可用性 SLA 维持在当前水平。图表直观对比了潜在的指数级增长趋势和通过 LBS 实现的理想的平缓趋势。这强烈表明 LBS 被视为管理未来高容量 SSD 带来的 SLA 挑战的必要技术。图中标注的特定块大小(4KB, 16KB, 32KB, 64KB)表明了在 LBS 上下文中考虑或利用的块的规模。

文章主要内容

• LBS技术背景:文章深入探讨了SSD架构设计中面临的挑战,特别是在逻辑块地址(LBA)与内部单元(IU)大小匹配问题上的权衡。随着数据爆炸式增长,SSD性能优化变得至关重要,三星等行业领导者正积极探索主机操作系统层面的优化方案,如大块大小(LBS)技术。

• LBS技术原理:LBS技术通过在主机操作系统层面启用大块大小,更好地支持QLC和使用大IU的SSD。这种方法的主要优势在于其对现有主机软件生态系统的影响最小,几乎可以让所有主机软件“免费”获得收益。

• LBS技术优势:LBS技术保持了后向兼容性,并提供了一个选项,允许I/O对齐的确定性,通过选择使用扇区大小并将主机I/O与原子性对齐来实现。QLC SSD在采用这种方法后在数据库工作负载中的性能收益显著,包括TPS的提升和变异性的降低。

• LBS技术挑战:文章还讨论了增加LBA扇区大小的困难,包括广泛的软件生态系统依赖和遗留兼容性问题。

这次分享的内容就到这里了,或许以下几个问题,能够启发你更多的思考,欢迎留言,说说你的想法~

-

除了 LBS,未来还有哪些潜在的技术或架构创新能够进一步提升高密度 QLC SSD 的性能和可靠性,使其更广泛地应用于企业级存储? -

考虑到 QLC SSD 在特定工作负载(如缓存命中率高或以读取为主)下的表现尚可,您认为在实际部署中,应如何根据应用场景精确选择 QLC 或 TLC SSD,以达到成本与性能的最佳平衡? -

LBS 技术的推广需要整个生态系统的协作,您认为哪些因素是推动或阻碍 LBS 广泛落地的主要力量?

原文标题:Impact of High Capacity and QLC SSD

Notice:Human's prompt, Datasets by Gemini-2.0-flash-thinking

公众号:王知鱼,专注数据存储、云计算趋势&产品方案。

PPT取自 Samsung 半导体 高级工程师 Hyung-Seuk Kim,在SNIA 存储开发者大会(24)上的汇报材料。